こんにちは!自然言語処理(NLP)・大規模言語モデル(LLM)の解説記事や書籍を書いている、

すえつぐです!

お知らせ:著書 『誰でもわかる大規模言語モデル入門』 を日経BPより出版しました。

こんにちは!自然言語処理(NLP)・大規模言語モデル(LLM)の解説記事や書籍を書いている、

すえつぐです!

お知らせ:著書 『誰でもわかる大規模言語モデル入門』 を日経BPより出版しました。

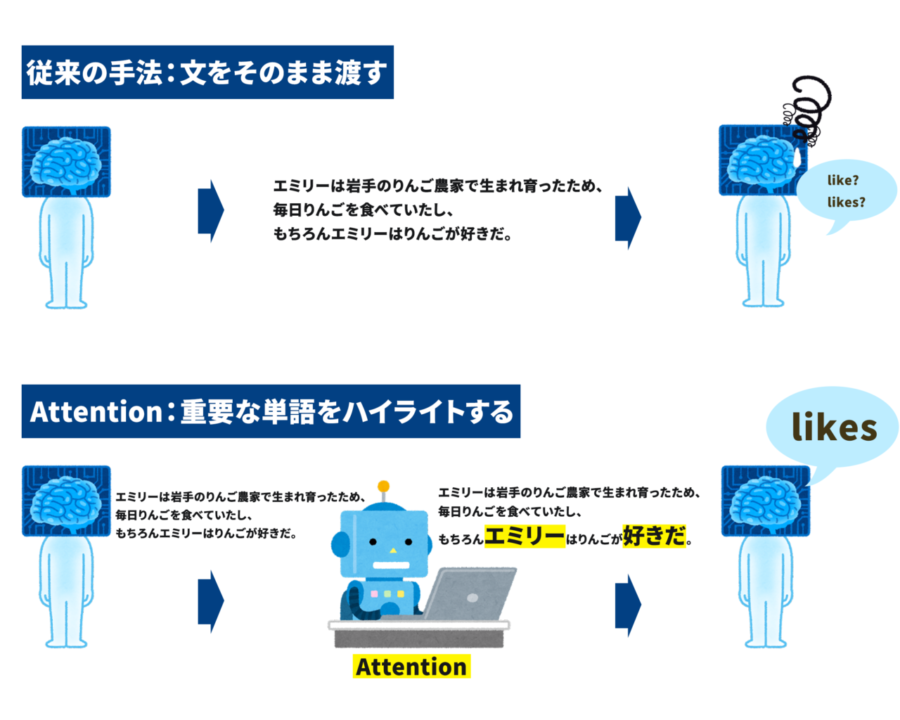

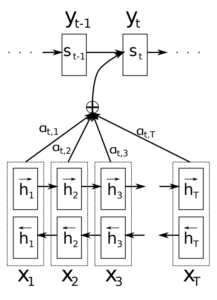

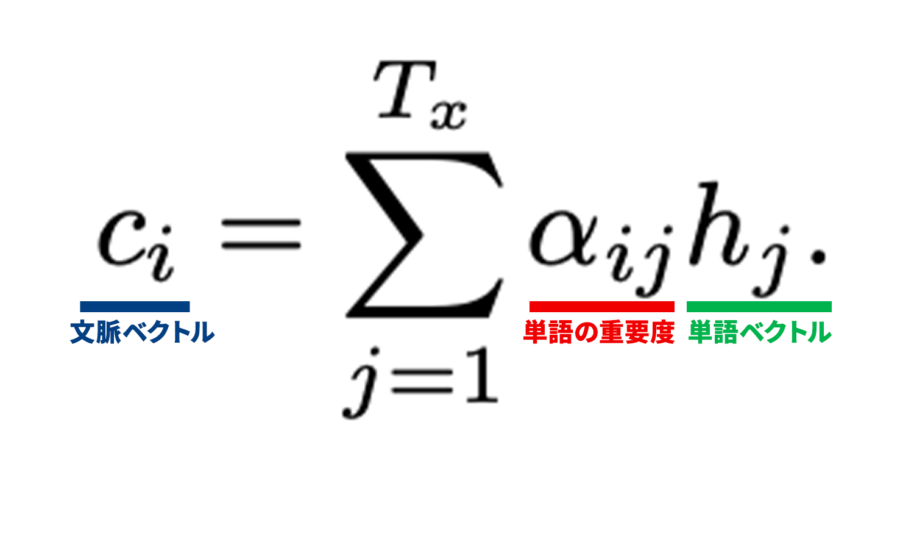

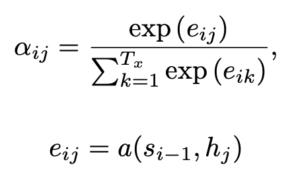

Attentionは自然言語界のブレイクスルーと言われ、BERTやGPT-3といった最先端技術を理解する上で必須の仕組みです。

このページでは「Attention」についてわかりやすく、そして深く解説していきます。

ここまでの学習、お疲れさまでした。そして本記事を最後まで読んでいただきありがとうございました!

ここからは、おすすめの書籍を紹介します。この記事で興味を持った方は、本を読めばさらに実践的な力が手に入るはずです。

特徴

・LLMの仕組みを、数式を使わず図で解説

・LLMを使った自動化をPythonコードで実装

今からLLMを体系的に学びたい、LLMを使った自動化や新機能を実装してみたいという方におすすめです。

以下のAmazon概要欄にて本の一部が無料で公開されていますので、ぜひ覗いてみてください。

残念ながらAttentionだけに関する書籍はありませんが、以下の書籍でAttentionとTransformer両方を学ぶことができます。

自然言語処理のおすすめ書籍・オンラインコースは上のページでまとめて紹介しています。

テーマごとに厳選した書籍、そもそもNLPは何から学べば良いか?などを網羅的にまとめています。

「NLPを最短で体系的に学びたい」という方は是非ご覧ください。

おすすめの勉強ステップ

1. 概要・大枠を知る。

Webサイトなどで概要を理解する(本サイトはこのステップの支援を目指しています。)

詳細を学ぶ際に、より効率良くインプットできる。

2. 詳細を知る、理解を深める。

書籍、論文でより詳しく学ぶ。

3. 実践・アウトプット

SignateやKaggleに参加してモデルを作ってみる、勉強したことをブログにまとめる。

個人的には、データサイエンス、特にNLP関係の本は難しく、いきなり本を読むと挫折してしまう人が多いと感じています。

このサイトで概要・全体像を理解してから本を読むことで、より理解しやすく挫折も少なくなるはずです。(その役に立てるよう記事を執筆していきます!)

原論文

Neural Machine Translation by Jointly Learning to Align and Translate