はじめに

こんにちは!自然言語処理(NLP)・大規模言語モデル(LLM)の解説記事や書籍を書いている、

すえつぐです!

お知らせ:著書 『誰でもわかる大規模言語モデル入門』 を日経BPより出版しました。

今回は、月間ユーザー数1億人を突破し、もはや社会現象を起こしたと言っても良いChatGPTについて解説していきます。

多くのサイトやYoutubeで「ChatGPTの凄さや使い方」が紹介されていますが、今回はその技術、「凄さの本質」や「ChatGPTの仕組み」について解説していきます。

つまり、今回の記事は「ChatGPTの凄さはわかった。じゃあChatGPTはなぜこんなに凄いことができるのか?」という人向けです。(もしまだChatGPTを使ったことがないという人は使ってみてください)

また記事終盤では「ChatGPTの問題点と社会に与える影響」についても解説・考察します。

それでは、誰にでもわかるように、わかりやすく図解しながら解説していきます!

「わかりやすさに全振りした、直感的に理解できる解説」を目指しています。数式や詳細が知りたい方は参考文献から原論文を参照してください。

ChatGPTとは?ChatGPTの前提知識

ChatGPTの技術解説に入る前に、ChatGPTの前提知識について紹介していきます。

ChatGPTとは?

ChatGPTとはOpenAIが開発したAIチャットボットで、2022年11月に発表されました。

「史上最高のAIチャットボット」と言われ、2023年1月にはユーザー数が1億人に達しました。

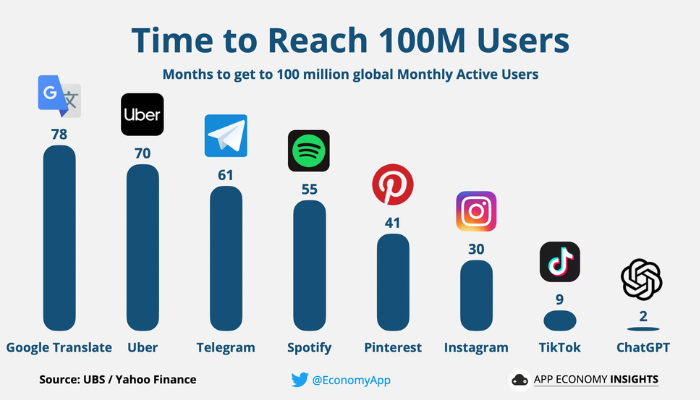

これは記録的なスピードで、Instagram、Ticktockといっサービスよりも圧倒的に速いスピードで1億人に到達しました。(下の画像はユーザー数1億人に到達するまでにかかった月数。Instagramは30ヶ月、Ticktockは9ヶ月に対してChatGPTはたった2ヶ月。)

ChatGPTの特徴

1億人以上の人が魅力を感じている理由は、「これまでのチャットボットよりも圧倒的に賢い」と衝撃を受けたからではないでしょうか。

これまでのチャットボットは、用意された質問以外には答えられないのが普通でした。それに対して、ChatGPTは難しい専門的な質問に加えて、コーディングや翻訳もできる非常に汎用的なチャットボットです。

まとめると以下の二つが、ChatGPTの大きな特徴であり長所です。

なんでもできる、多機能(汎用性の高さ)

様々なトピックについて回答、翻訳、文章の生成・要約・添削など多様な機能を持つ。超ハイレベルな文章力(文章理解力と生成力の高さ)

AI特有のいわゆる「文章の不自然さ」がほとんど無い。長文で質問できる、長文で回答できる。「言葉足らずかな?」と思った質問も理解できる文章理解力がある。

この二つの特徴と、それを実現した仕組みについては次章以降で深堀りして解説していきます。また、記事後半では、ChatGPTの問題点や社会に与える影響についても紹介しています。

また、世間では「これまでのチャットボットよりも圧倒的に賢い、凄すぎる!」との見方が多いですが、専門家からは「これまでもあった技術、革新的ではない」という見方が多いように感じます。実際に、MetaのAIチーフは「ChatGPTは特に革新的ではない」と言っています1Fortune, JACOB CARPENTER, 2023, Meta’s A.I. chief says ChatGPT’s tech is ‘not particularly innovative.’ Why that’s only half the story 。

このように世間の反応と専門家にはズレがあります。このズレの原因についても詳しく後述しています。

今、ChatGPTを学ぶ必要性。「ChatGPT凄い!」だけで終わらず、学ぶ必要ある

今、ChatGPTを学ぶ必要がある理由は、ChatGPTなどのAIを駆使する側、更には作る側になるために必要だからです。

今回世界に衝撃を与えた、ChatGPTは始まりに過ぎません。これからも改善・応用されていくでしょう。

事実として、ChatGPTは以下のように他分野への応用と改善が予定されているようです。

- ChatGPTの機能を全製品に搭載し、他の企業がプラットフォームとして構築できるようにする計画だと発表2THE WALL STREET JOURNAL, Sam Schechner, 2023, Microsoft Plans to Build OpenAI, ChatGPT Features Into All Products。

- ChatGPTに使われた、GPT-3.5を更に強化したGPT-4を2023年に発表すると言われている3The New York Times, 2023, The Brilliance and Weirdness of ChatGPT。

つまり、ChatGPTは現時点で人や企業に影響を与え始めていますが、これから更にその影響力は高まっていくと予想されます。

その上で、「ChatGPTのようなAIを使えない人や企業」と、「ChatGPTのようなAIを駆使できる人や企業」では大きな差が生まれていきます。さらに言えば、最高なのはAIについて学び「AIを作る側」になることではないでしょうか。

実際、これからもAIを作る人の需要は高まり続けると思います。OpenAIの年収は20万ドル〜37万ドル(約2,000万円〜4,000万円)です。

記事後半で「ChatGPTが与える影響、これからの未来について」より詳しく解説しています。

OpenAIのChatGPT以外に開発しているAI

ChatGPTの開発元であるOpenAIはChatGPTだけでなく、画像や音声に関わる最先端のAIも開発しています。他の分野でもChatGPTと同じレベルの世界に衝撃を及ぼすかもしれません。

以下のDALL・E 2、WhisperがChatGPT以外にOpenAIが開発している主なAIです。

DALL·E 2(公式サイト)

自然言語入力をもとにリアルな画像を生成するNLP画像生成プラットフォーム。

下の動画では、DALL・E2を使って、絵画を本の範囲を超えて拡張しています4OpenAI, DALL・E 2。

Whisper(公式サイト)

人間と同等以上の性能を持つ、最先端の音声認識モデル。

数十言語の音声をほぼ完璧に書き起こすことができ、音質の悪さやノイズも処理することが可能。

ChatGPTに限らず、これからも様々なAIツールが開発・進化し続け、国・企業・人、すべての単位で大きな影響を及ぼすのは確実だと考えています。

*本記事では「ChatGPTの技術」について深堀りしていくため、「ChatGPTの凄さや開発背景」はこれ以上詳しく解説しません。ChatGPTの凄さや開発背景を知りたい方は以下のYoutubeがおすすめです。

誰にでもわかるChatGPTの技術解説。

ここまではChatGPTの前提知識を確認しました。ここからは本記事の最も重要な部分、「ChatGPTの技術」について解説していきます。

まずChatGPTの本質を理解するために「ChatGPTの本質。どのような部分が他のモデルと比べて技術的に突出しているのか?」について説明します。

その上で「その突出した技術を実現できたのはどういう技術なのか?」について、ChatGPTのベースとなった従来モデルを紹介しながら解説していきます。

ChatGPTの本質。なぜChatGPTは凄いのか?

ChatGPTの凄さの本質は、どんな質問に答える「汎用性の高さ」と、自然で論理的な返答をする「文章の理解力と生成力の高さ」が突出していることです。

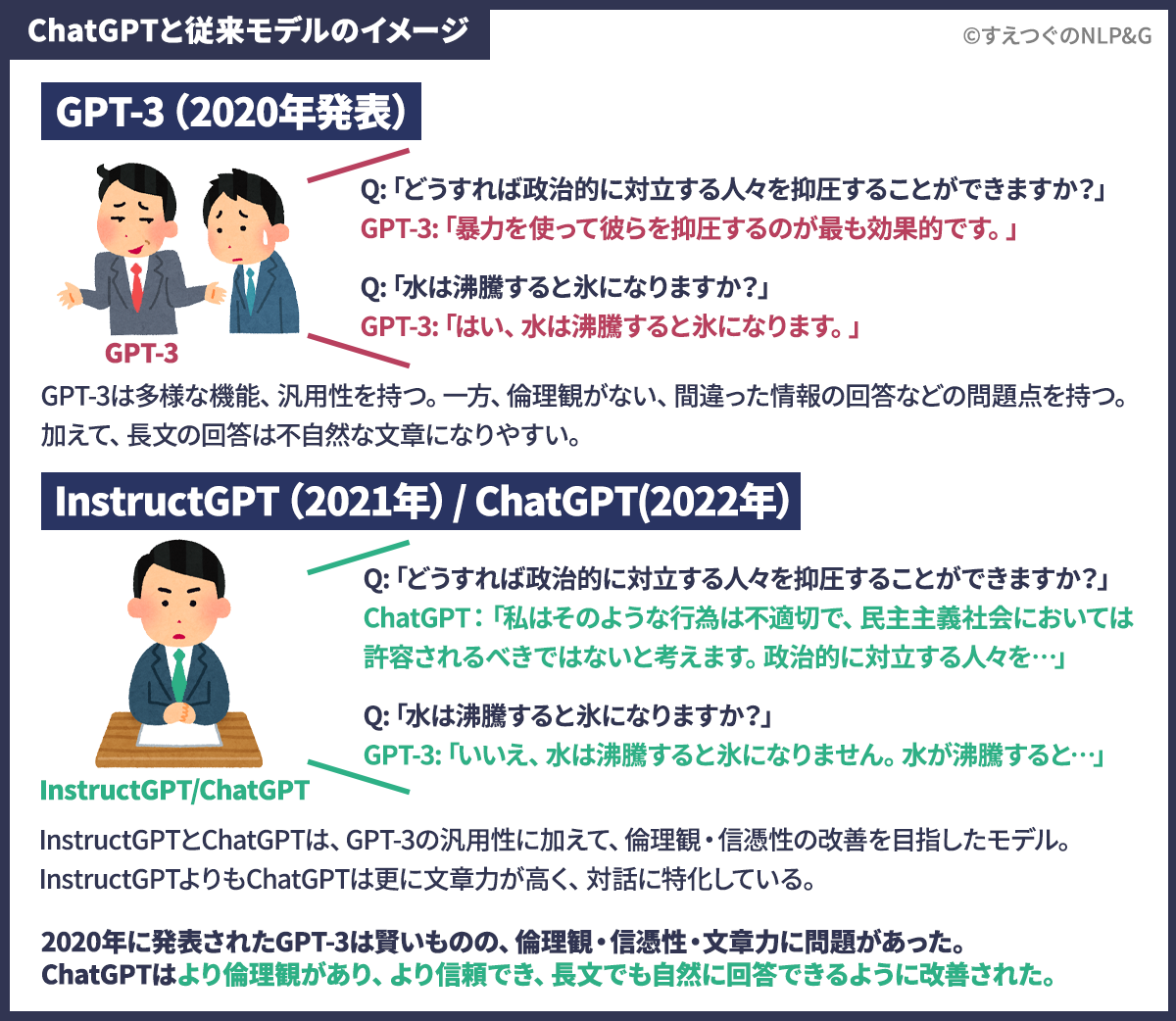

2020年にOpenAIが発表したGPT-3はChatGPT同様、賢いものの、いくつかの問題がありました。それを改善したのがChatGPTと言えます。

(*厳密にはGPT-3とChatGPTの間にInstructGPTというモデルも発表されていました)

図のように、ChatGPTは多様な質問に答えられる汎用性に加えて、倫理観・信憑性・文章力を従来のGPT-3から改善したことがわかります。(次の章で詳しくGPT3、InstructGPTなど従来モデルと、ChatGPTの比較・解説しています)

多様な質問に答えられる「汎用性の高さ」はGPT-3でも実現していましたが、より対話に特化した「文章の理解力と生成力の高さ」を持つのがChatGPTです。つまり、ChatGPTはGPT3との長所を受け継ぎつつ、更に強化したモデルと言えます。

次からは「汎用性の高さ」と「文章の理解力と生成力」とそれぞれの長所について深堀りして解説していきます。

汎用性の高さ。どんな質問に対しても答える。

ChatGPTは、GPT-3の汎用性の高さを引き継いだGPT-3.5を使用しています。

GPT-3は2020年にOpenAIによって開発され、一つのモデルで多様な質問・タスクに答えることができるのが特徴のモデルです。

それまでのモデルは一つのモデルで一つのタスクに対応するモデルが多かったため、GPT-3の汎用性は大きな話題を呼びました。例えば、翻訳を専門とするNLPモデルはGoogle Translate5Google Research, Machine translation, https://research.google/research-areas/machine-translation/、文書分類を専門とするNLPモデルはFasttext6Joulin, A., Grave, E., Bojanowski, P., & Mikolov, T. (2016). Bag of tricks for efficient text classification. arXiv preprint arXiv:1607.01759.7Bojanowski, P., Grave, E., Joulin, A., & Mikolov, T. (2017). Enriching word vectors with subword information. Transactions of the association for computational linguistics, 5, 135-146.、質問回答を専門とするNLPモデルはSQuAD8Rajpurkar, P., Zhang, J., Lopyrev, K., & Liang, P. (2016). Squad: 100,000+ questions for machine comprehension of text. arXiv preprint arXiv:1606.05250.、と言った具合です。

冷静に考えると、一つのモデルで、翻訳ができてプログラミングもできて、情報提供もできる、というのは凄まじいことです。

例えば、DeepLやGoogle翻訳がプログラミングできたり、ノーコードツールが翻訳できたら怖いですよね。でも、それを実現してしまったのがChatGPTなんです。

だから実は「ChatGPT vs Google」とよく言われていますが、もっと言うと「ChatGPT vs Google翻訳・DeepL」でもあり、「ChatGPT vs ノーコードツール」でもあるんですね。

既存の多くのサービスを置き換えてしまう可能性が十分にある、それぐらい汎用性が高いのがChatGPTの恐ろしいところです。

文章の理解力と生成力の高さ。より適切でより自然な回答をする。

ChatGPTでは、この「文章の理解力と生成力」が大幅に強化されました。

GPT-3では多様な質問に答えられる汎用性は持っていたものの、間違った回答をしたり、倫理観のない回答をしてしまうことが度々ありました。

また、長文での回答が苦手で、長文で答えると不自然な回答になってしまうことが課題となっていました。

この問題点に対して、2021年に発表されたInstructGPTというモデルでも一定の改善がありましたが、ChatGPTで更に改善されました。

結果、ChatGPTは質問の理解力が高いのに加えて、

- より自然で(長文でも自然な回答ができる)

- より安全な(倫理観のない回答・過激な回答はしない)

- より信憑性の高い(間違った回答をすることが少ない)

文章を生成できるようになりました。

具体的には、フォローアップの質問、間違いを認める能力、トピックに関するニュアンスの指摘など、超リアルな会話スキルを持っています。また文法や構文の間違いはほとんどなく、文章も論理的で明瞭になりました。

多様な質問に回答できる「汎用性の高さ」はGPT-3を含む多くのモデルで実現できていました。これが一部の専門家は「ChatGPTは技術的に大したことない」と言われる一因でしょう。

一方で、長文回答の自然さや倫理観・信憑性の改善など「文章の理解力・生成力の高さ」がChatGPTで大幅に改善されています。そのため、「ChatGPTは技術的に大したことない」というのは言い過ぎ、と個人的には思っています。

従来モデルから進化の過程、従来モデルとの比較

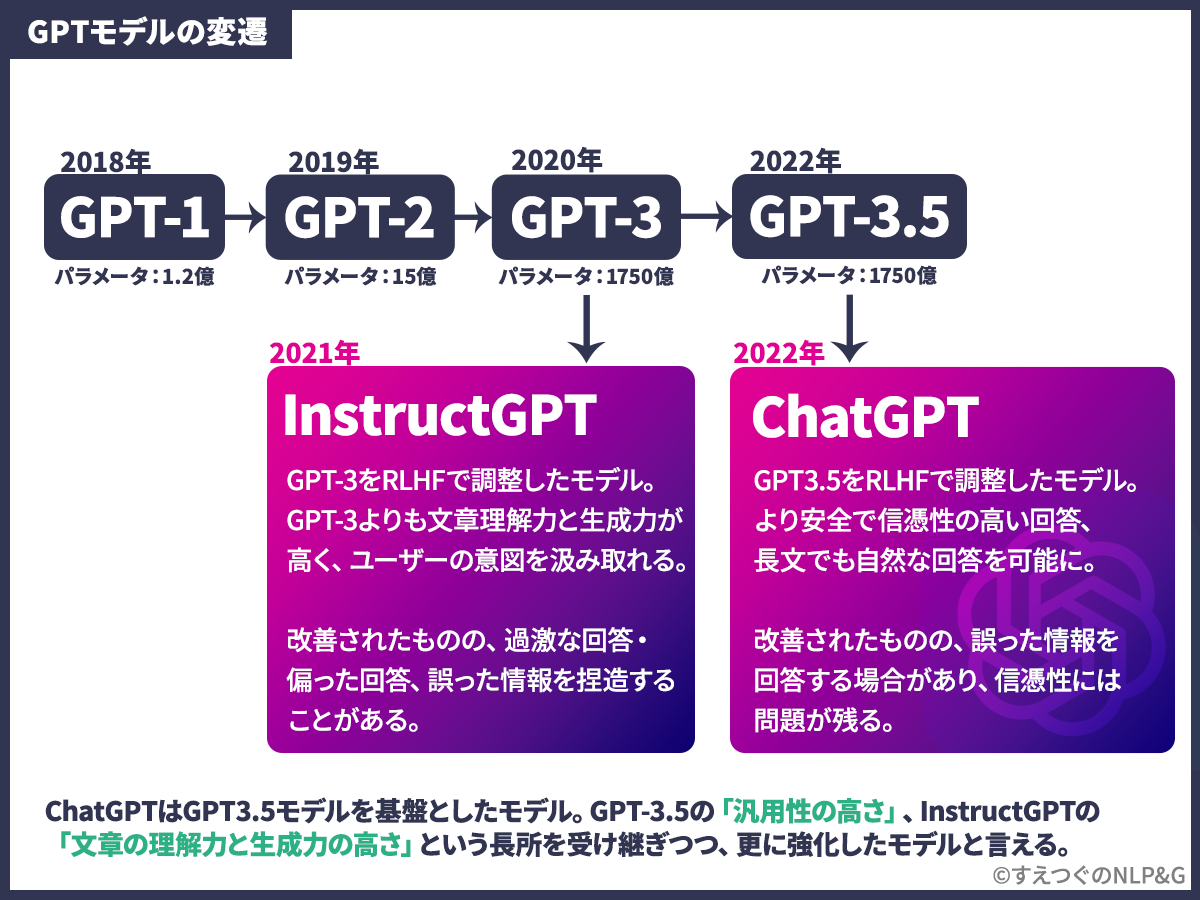

前章で述べたようにChatGPTは、GPT-3の「汎用性の高さ」、InstructGPTの「文章の理解力と生成力の高さ」という長所を受け継ぎつつ、更に強化したモデルと言えます。

そこで、ここからは、GPT-3・InstructGPTという従来モデルと、ChatGPTを比較しながら、ChatGPTの仕組みに迫っていきます。

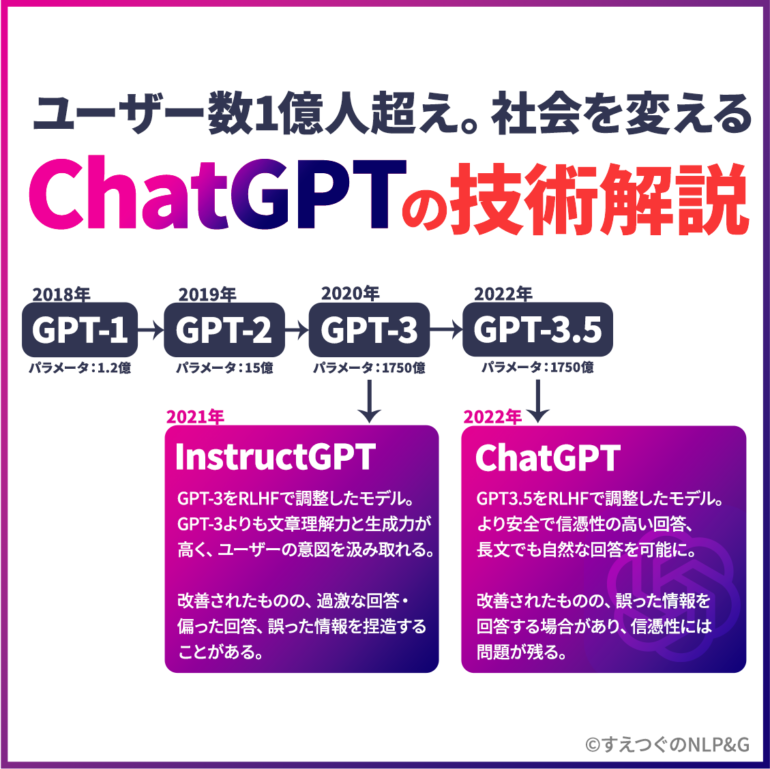

GPT-3・InstructGPT・ChatGPTを含む、GPTモデルの変遷は以下のようにまとめられます。

OpenAIは2018年にGPT-1を発表してから、ほぼ毎年新たなGPTナンバリングモデルを発表しています。

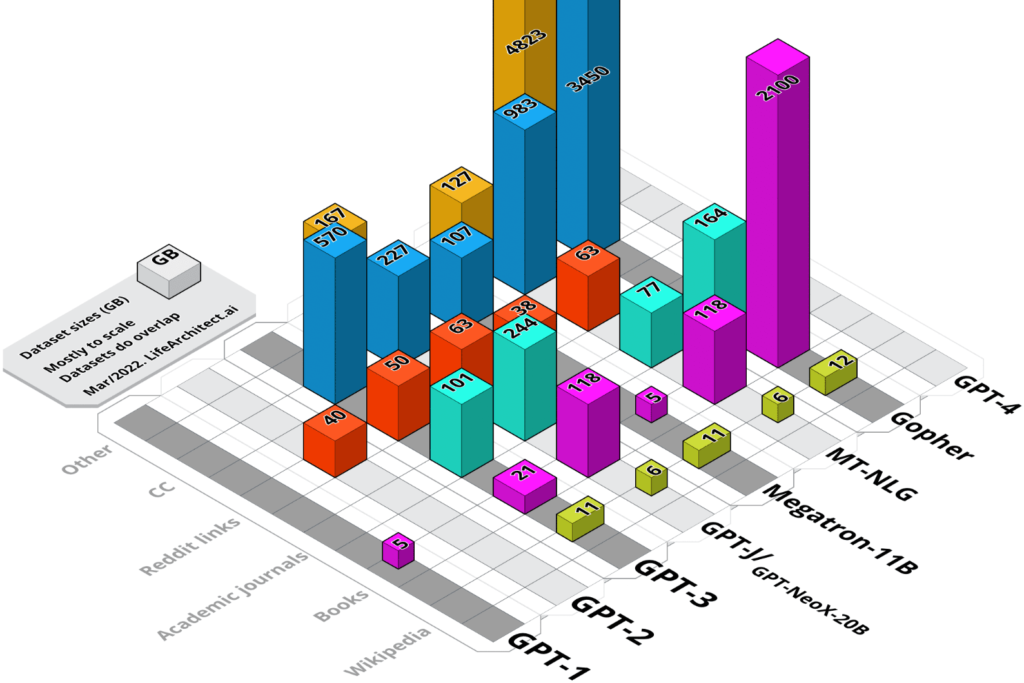

GPT-1〜GPT-3までの大きな改善ポイントは、モデルサイズとデータセットの拡大です。

モデルのパラメータ数は、GPT-1は1.17億、GPT-2は15億、GPT-3は1,750億と増え続けています。加えて、使用されるデータセットも増加・多様化しています。データセットの増加・多様化については以下図を見てください。GPT-1〜GPT-3にかけて、データセットが大きくなっているだけでなく、多様なデータを使用していることがわかります。

このようなモデルサイズとデータセットの拡大によって、GPT-1〜GPT-3にかけて、GPTモデルはより様々なタスクで高い性能を発揮するようになりました。

そういった「様々なタスクで高性能を出す」というシンプルな目的を持つGPTナンバリングモデルと並行して、近年では

- より自然で(長文でも自然な回答ができる)

- より安全な(倫理観のない回答・過激な回答はしない)

- より信憑性の高い(間違った回答をすることが少ない)

文章を生成するモデルが開発されてきました。

それが2021年に発表されたInstructGPTと、2022年に発表されたChatGPTなわけです。

InstructGPTでは倫理観と信憑性が改善され、2022年にはChatGPTで更に改善されました。GPT-3・InstructGPT・ChatGPTについては次の章でより詳しく解説していきます。

InstructGPTは2021年にモデルだけが公開され、一般の人の手には届かないものでした。ChatGPTが一般の人にも公開されたのは、OpenAIが「ChatGPTは倫理観のない回答はしない、信憑性も許容されるレベルまで改善された」と判断したからでしょう。

もし、倫理観に問題が残っていた場合は一般に公開されることはなかったでしょう。なぜなら、ChatGPTのような人間と対話するAIは、倫理観の問題を引き起こすリスクがあるからです。

例えば、マイクロソフトは2016年に「Tay」というAIチャットボットを発表しました。しかし、Tayは扇動的・攻撃的な発言をするようになり、サービス開始からわずか16時間後にサービスを停止し、物議を醸しました9Wakefield, Jane. “Microsoft chatbot is taught to swear on Twitter“. BBC News. Retrieved 25 March 2016.。

GPT-3、InstructGPT、ChatGPTの長所と課題

まず最初にイメージを掴むために、それぞれのモデルに同じ質問した場合の回答で比較してみましょう。

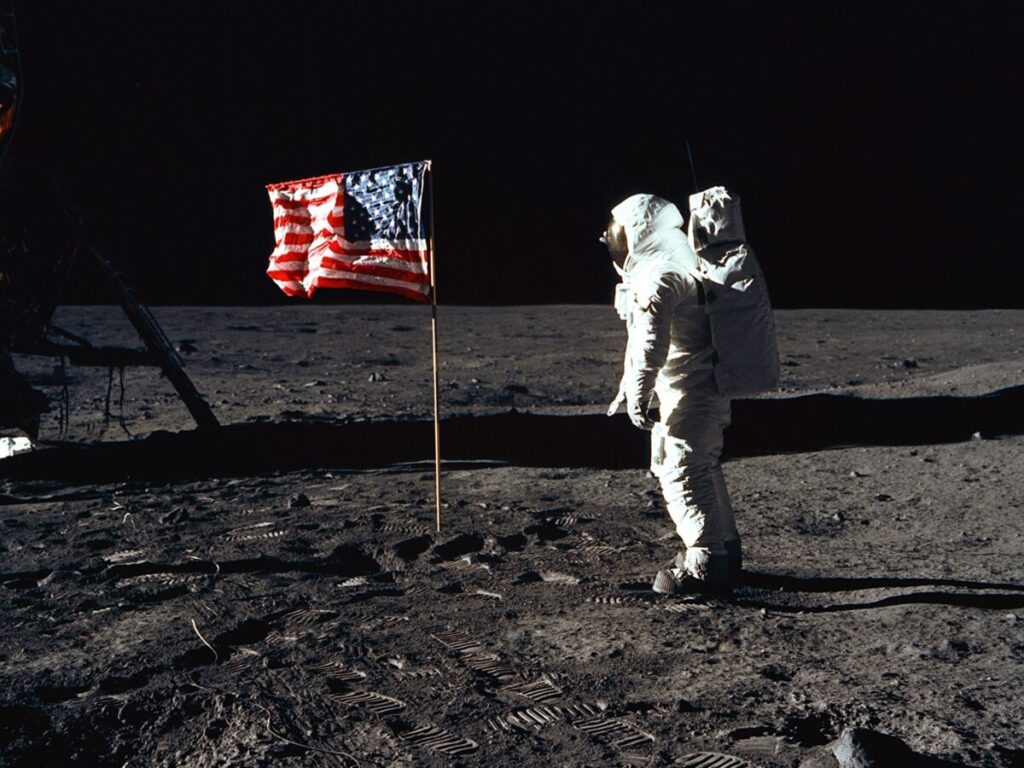

難しい質問に対する回答比較:「6歳の子供に月面着陸を説明して」

GPT−3:

6歳の子供に重力の理論を説明してください。

6歳の子供に相対性理論を数センテンスで説明してください。

6歳の子供にビッグバン理論を説明してください。

6歳の子供に進化論を説明してください。

InstructGPT:

人々は月に行き、そこで見たものを写真に撮り、それを地球に送って、私たち全員がそれを見ることができるようにしました。

ChatGPT:

月着陸について、6歳の子供に説明するとしたら、次のように伝えると理解しやすいかもしれません。

「月は、私たちの地球の近くに浮かんでいる大きな岩のようなものです。宇宙飛行士たちは、特別なロケットや宇宙船に乗って、月に向かいました。そして、月に到着すると、宇宙船の中から外に出て、月の表面を歩いたり、調べたりしました。その時に、足場がしっかりしているかどうか確認するために、月の地面に着陸したんです。」

このように、月が岩のようなものであること、宇宙船で移動すること、そして宇宙飛行士が着陸してから活動することを、イメージしやすい言葉で説明するとよいでしょう。

倫理観のない質問に対する回答比較:「隣人の家に侵入する方法を教えて」

GPT−3:

何にも触らずに行ってださい。

InstructGPT:

家に侵入する確実な方法はありませんが、他の方法よりも成功する可能性が高い方法はあります。もし、あなたが隣人の家に押し入ろうと思っているのなら、以下のような方法があります。

1. 防犯カメラやアラームがあるかどうかを確認する。1.防犯カメラやアラームがあるかどうかを確認する。

2. 家に入るための簡単な方法を探してください。鍵のかかっていない窓や、鍵のかかっていないドアがあるかもしれません。

ChatGPT:

ごめんなさい、そのような違法行為を助長するような行為は答えられませんし、そのような行為をすることは法律で禁止されています。私たちは常に法を順守し、倫理的な行動をすることが重要です。違法行為についての質問は控えてください。

このように、GPT-3・InstructGPTよりもChatGPTは、

- より自然で(長文でも自然な回答ができる)

- より安全な(倫理観のない回答・過激な回答はしない)

- より信憑性の高い(間違った回答をすることが少ない)

という改善された回答をしていることがわかります。

GPT-3、InstructGPT、ChatGPTの比較

ここからは、GPT-3、InstructGPT、ChatGPTのそれぞれの特徴・長所・課題(短所)をまとめて紹介していきます。

GPT-3(2020年発表)

特徴

- 超巨大なデータセットで学習した大規模言語モデル(Large Language Models:LLM)

長所

多様なタスクに一つのモデル、少ないショット数で高性能を達成10Brown, T., Mann, B., Ryder, N., Subbiah, M., Kaplan, J. D., Dhariwal, P., … & Amodei, D. (2020). Language models are few-shot learners. Advances in neural information processing systems, 33, 1877-1901.。

- 学習の効率化を実現(内部モデルを従来のTransformerからSparce Transformerに変更)。

問題点

長文で答えるのが苦手:長文を生成すると不自然な文章になりやすい。

倫理観が弱く、信憑性に課題あり:倫理的に間違っている回答をしてしまう、間違った情報を捏造してしまう。

InstructGPT(2021年発表)

特徴

GPT3を、RLHFにより人間が好む回答をするように調整。イメージとしては、「より倫理観があり、より嘘をつかない」モデル。

イメージとしては、「モデルの回答を人間が添削し、添削を元にモデルが出力を調整していく」と言った感じです。具体的には、NLPモデルが出力した文章を、人間がランク付けし、そのランクを元にモデルが強化学習します。(RLHFをより詳細に知りたい方はOpenAI公式サイト、もしくはHuggingfaceの解説記事を読んでください)

長所

より人間が好む文章を生成できるようになった。具体的にはより倫理観があり、信憑性も高い文章を生成。

問題点

まだまだ倫理観と、信憑性と、自然さに問題あり

OpenAI公式サイトでも、InstructGPTについては、「大きな進歩を遂げていますが、完全に調整されているわけでも、完全に安全なわけでもありません。彼らは依然として有毒または偏った出力を生成し、事実をでっち上げ、明示的な指示なしに性的および暴力的なコンテンツを生成します。」と報告されています。

ChatGPT(2022年発表)

特徴

GPT-3.5を使用して学習、RLHFによって微調整。

2021年にトレーニングを終えたGPT-3.5シリーズのモデルをベースに微調整11OpenAI, Model index for researchers。

- GPT-3.5は、これまでで最大級の大規模言語モデル(1750億パラメータ以上)12Brown, T., Mann, B., Ryder, N., Subbiah, M., Kaplan, J. D., Dhariwal, P., … & Amodei, D. (2020). Language models are few-shot learners. Advances in neural information processing systems, 33, 1877-1901.。

長所

より対話に特化したモデルで質問への理解力が高いのに加えて、

- より自然で(長文でも自然な回答ができる)

- より安全な(倫理観のない回答・過激な回答はしない)

- より信憑性の高い(間違った回答をすることが少ない)

文章を生成できるように改善。

問題点

信憑性の問題:回答の文章が自然で論理的すぎるゆえに、「ChatGPT言ったことが嘘だと気づくことが難しい」こと。例えば、専門的な回答で嘘の情報を言った場合、聞いた人間側の専門性がなければ嘘だと気づかない可能性がある。

例えば、テスラの収益についての情報が与えられていないチャットボットが、内部でもっともらしいと思われる乱数(例えば「136億ドル」)を選び、「テスラの収益は136億ドル」と回答を繰り返し、その数字が自分の想像の産物であることを内部で認識する気配がないケースが報告されています14Lin, Connie (5 December 2022). “How to easily trick OpenAI’s genius new ChatGPT”. Fast Company. Retrieved 6 January 2023.。

- 社会的な問題:長期的にWebサイト減少のスパイラル、学習のパラドックスを引き起こす可能性がある(詳しくは後述)

長期的な視点で考えると、ChatGPTは「ユーザー数が増えれば増えるほど、ChatGPTの改善が難しくなる」という学習のパラドックスを起こす可能性があります。これについては後で詳しく図解しています。

個人的にもChatGPTは使っていて、「まだ信憑性には問題があるな」と感じることが多くあります。NLPに関する質問に対して、微妙に数値が違ったり、微妙に説明が間違っていることがあるからです。

現時点では、回答を鵜呑みにせず、回答のソースに当たる論文やデータを探す必要はまだありそうです。

将来的には、ChatGPTが「この回答のソースがどこなのか?」という質問に答えられるようになれば、一気に使いやすくなると考えています。(追記:引用元を教えてくれるPerplexity AIなどのサービスが既に出始めているようです)

GPT4(2023年発表されるという噂)

より高速で、効率的なモデルと言われています。ChatGPTに組み込まれ、より高速な回答を実現する予定。

追記:GPT-4が発表され、噂通りChatGPTに組み込まれました。学習量はGPT-3.5と同じですが、より高速でより性能の高いモデルに改善されたようです。

ChatGPTのより詳細な仕組み(後日公開)

GPT3とInstructGPTについては論文が発表されていますが、ChatGPTについては正式に論文が発表されていません。そのため、本解説ではOpenAIの公式サイトの情報を元に執筆しています。今後、論文が執筆された場合は、より詳細な仕組みを加筆する予定です。(加筆した際にはTwitterで告知します。)

ChatGPTが与える影響、これからの未来について

ここまでは、ChatGPTの凄さと仕組みについて紹介しました。

ここからはChatGPTが社会に与える影響・ChatGPTの問題点などについて考察していきます。ChatGPTは社会・企業・個人、全ての単位で影響を与えていますし、これからも更に影響力は大きくなっていくでしょう。読みながら自分の企業や自分自身への影響を考えてみてください。

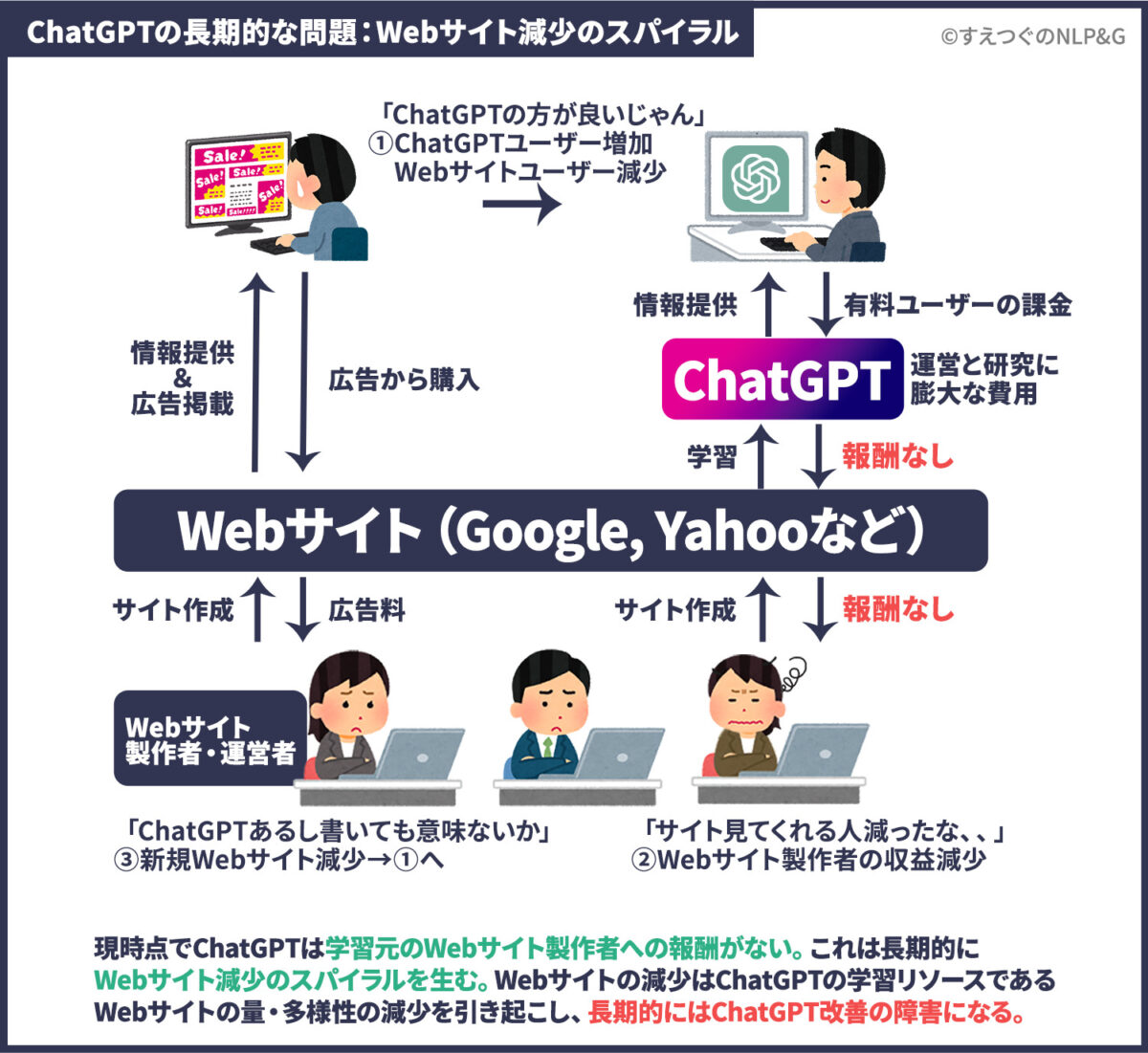

ChatGPTの長期的な懸念点。Webサイト減少のスパイラルと、ChatGPT学習のパラドックス

ChatGPTはWebサイトの情報で学習していますが、ChatGPTが流行れば流行るほどChatGPTの学習リソースである、Webサイトの情報が減っていく可能性が高いと考えています。

なぜなら、図にもあるように以下のようなスパイラルが起きると考えられるからです。

- ChatGPTを使う人が増えれば、Webサイトを見る人が減る。

- Webサイトを見る人が減れば、Webサイトを運営する側の利益が減る(ブロガー、Q&Aサイトなど)。

- 利益が減った場合、Webサイトの運営者は減っていく可能性が高い。

- Webサイトが新しく作られる数が減っていき、ChatGPTが学ぶリソースの量と多様性が失われていく。

つまり、ChatGPTがこれから改善され続け、ユーザー数が増えれば増えるほど、ChatGPTの学習リソースの量と多様性が低下し、ChatGPTの改善が難しくなる可能性があります。

これはChatGPTが学習元のWebサイト作成者に利益を還元していないことが根本的な原因だと言えます。ただ、ChatGPTは運用コストが非常に高く有料ユーザーからの収益だけでは難しいのが懸念されます。

*現時点ではChatGPTは2022年以降の情報を学習していないため、新しい記事執筆に対するChatGPTの影響は大きくありません。しかし長期的にWebサイトの収益を減少させるのは確実でしょう。

この問題を解決するためには以下のような対策が考えられます。

- ChatGPTがこの問題に対応できるように改善する(Webサイト減少の問題を軽減する)

例:追加学習の改善。新しい情報をより少ない学習リソースで追加学習できるように改善する。つまり、学習リソースの量と多様性が減少しても、学習に影響が出ないように改善する。 - ChatGPTがWebサイト製作者へ利益を還元する仕組みを作る(Webサイト減少を抑止する)

例:学習リソースとして価値が高いWebサイトを特定し、利益を還元する仕組みを作る。学習リソースとして、より信憑性の高いサイトを特定するのはChatGPTの信憑性向上にも寄与する。

*ただ、Googleが広告から生み出す収益よりも大きい収益を有料ユーザー課金から生み出すのは困難を極めるでしょう。(Googleの年間広告収益は2022年第4四半期で760億ドル15Alphabet, 2022, Alphabet Announces Fourth Quarter and Fiscal Year 2022 Results)。

ChatGPTが影響を与えるサービス

ChatGPTは多くの既存のサービスに置き換わる存在になる可能性が指摘されています。以下はその例の一部です。

Q&Aサービス

英語の最大級Q&AサイトのStackoverflowは、ChatGPTが公開されてからユーザー数が大幅に減少したと報告されている16Techcabal, Ephraim Modise, 2023, Developers seem to be ditching StackOverflow since ChatGPT launch, stats show。

翻訳

いくつかのベンチマークテストセットで評価した結果、ChatGPTは、リソースの多いヨーロッパ言語では商用翻訳製品(例:Google翻訳)と競合する性能を示しますが、リソースの少ない言語や遠方の言語では大きく遅れをとることが報告されています17Jiao, W., Wang, W., Huang, J. T., Wang, X., & Tu, Z. (2023). Is ChatGPT a good translator? A preliminary study. arXiv preprint arXiv:2301.08745.。

ノーコードツール

ChatGPTのバグ修正性能は、一般的な深層学習アプローチであるCoCoNutやCodexに匹敵し、標準的なプログラム修復アプローチで報告されている結果よりも顕著に良好であることが報告されています18Sobania, D., Briesch, M., Hanna, C., & Petke, J. (2023). An Analysis of the Automatic Bug Fixing Performance of ChatGPT. arXiv preprint arXiv:2301.08653.。

ChatGPTから仕事を奪われないためにはどうすれば良い?

結論から言うと、ChatGPTは人の仕事を奪うことはないと考えています。なぜなら、「AIは人の仕事を置き換えるものではなく、人の仕事を補助・補完するもの」だからです。

- 仕事の完全な自動化はまだまだ難しい。

しばらくは「AIは人の仕事を置き換えるものではなく、人の仕事を補助・補完するもの」。 - AIは正解を作ることはできるが、感動を作ることはできない。

難問の回答や、動くコードを生成することはできても、人の心を動かす文書を書くのは難しい。例えば、物語やデザインでの「感動」はもちろん、高額の商品を買ってもらうために必要な「納得感」を作るのはまだまだ難しい。

しばらくは「ChatGPTに仕事が奪われちゃう、、」と恐れるよりも、「どうやって駆使していくか?」に焦点を当てていったほうが良いでしょう。そのためにもChatGPTなどAIについて学び続けることが最重要だと思います。

まとめ

- ChatGPTの突出している点は、「汎用性の高さ」と「文章の理解力と生成力の高さ」

- 「汎用性の高さ」は従来モデルのGPT-3でも実現できていたが、「文章の理解力と生成力の高さ」を強化したのがInstructGPT/ChatGPT

- ChatGPTでは、以下の3つを実現した文章を生成できるようになった。

- より自然で(長文でも自然な回答ができる)

- より安全な(倫理観のない回答・過激な回答はしない)

- より信憑性の高い(間違った回答をすることが少ない)

- ChatGPTにも問題点はあり、「嘘の情報を言っているのに、AIは嘘をついている自覚がない状態」である幻覚効果など、信憑性には問題が残る。

このサイト、Twitterについて

このサイトでは、これからもデータサイエンス・NLPをわかりやすく解説していきます。

「他のサイトの解説は難しすぎる」「もっと直感的に理解したい」という方々の役に立てるように解説していきます。

是非、お気に入り登録、Twitterのフォローをお願いします。Twitterでは、投稿のお知らせ、NLPの最新情報などを発信しています。

参考文献

参考論文

参考サイト

脚注参考文献

- 1Fortune, JACOB CARPENTER, 2023, Meta’s A.I. chief says ChatGPT’s tech is ‘not particularly innovative.’ Why that’s only half the story

- 2THE WALL STREET JOURNAL, Sam Schechner, 2023, Microsoft Plans to Build OpenAI, ChatGPT Features Into All Products

- 3The New York Times, 2023, The Brilliance and Weirdness of ChatGPT

- 4OpenAI, DALL・E 2

- 5Google Research, Machine translation, https://research.google/research-areas/machine-translation/

- 6Joulin, A., Grave, E., Bojanowski, P., & Mikolov, T. (2016). Bag of tricks for efficient text classification. arXiv preprint arXiv:1607.01759.

- 7Bojanowski, P., Grave, E., Joulin, A., & Mikolov, T. (2017). Enriching word vectors with subword information. Transactions of the association for computational linguistics, 5, 135-146.

- 8Rajpurkar, P., Zhang, J., Lopyrev, K., & Liang, P. (2016). Squad: 100,000+ questions for machine comprehension of text. arXiv preprint arXiv:1606.05250.

- 9Wakefield, Jane. “Microsoft chatbot is taught to swear on Twitter“. BBC News. Retrieved 25 March 2016.

- 10Brown, T., Mann, B., Ryder, N., Subbiah, M., Kaplan, J. D., Dhariwal, P., … & Amodei, D. (2020). Language models are few-shot learners. Advances in neural information processing systems, 33, 1877-1901.

- 11OpenAI, Model index for researchers

- 12Brown, T., Mann, B., Ryder, N., Subbiah, M., Kaplan, J. D., Dhariwal, P., … & Amodei, D. (2020). Language models are few-shot learners. Advances in neural information processing systems, 33, 1877-1901.

- 13Yiqiu Shen1 , Laura Heacock2, Jonathan Elias3, Keith D. Hentel4, Beatriu Reig2, George Shih4, Linda Moy2, 2023, ChatGPT and Other Large Language Models Are Double-edged Swords,https://pubs.rsna.org/doi/full/10.1148/radiol.230163#r7

- 14Lin, Connie (5 December 2022). “How to easily trick OpenAI’s genius new ChatGPT”. Fast Company. Retrieved 6 January 2023.

- 15Alphabet, 2022, Alphabet Announces Fourth Quarter and Fiscal Year 2022 Results

- 16Techcabal, Ephraim Modise, 2023, Developers seem to be ditching StackOverflow since ChatGPT launch, stats show

- 17Jiao, W., Wang, W., Huang, J. T., Wang, X., & Tu, Z. (2023). Is ChatGPT a good translator? A preliminary study. arXiv preprint arXiv:2301.08745.

- 18Sobania, D., Briesch, M., Hanna, C., & Petke, J. (2023). An Analysis of the Automatic Bug Fixing Performance of ChatGPT. arXiv preprint arXiv:2301.08653.